Tarama Bütçesi (Crawl Budget) Nedir? Nasıl Optimize Edilir?

Tarama bütçesi (Crawl Budget), bir arama motorunun belirli bir süre dahilinde herhangi bir web sitesinde taramak istediği ve tarayabildiği maksimum sayfa sayısına verilen isimdir. Bütçe adı ile anılmasının en temel sebebi, Arama motorlarının internet dünyasında yer alan milyarlarca site ve sayfayı tarama noktasında kaynaklarını optimal kullanabilmek adına belirli kısıtlamalara gitmesi ve siteler için çeşitli faktörlere bağlı olan tarama limitleri belirlemesidir.

Tarama bütçesi sitenin teknik alt yapısının sağlığı, sunucu sağlığı, site içerik kalitesi (confidence skor) gibi etmenlere bağlı olarak değişiklik gösterebilir.

Site genel sağlığınıza (sunucu sağlığı da dahil olmak üzere) paralel olarak genellikle stabil olmak ile birlikte tarama bütçeniz artıp azalabilmektedir. Özellikle tarama bütçesinin istenmeyen şekilde azaldığı durumda, başta gün içerisinde çok sayıda içerik paylaşımı yapan web siteleri olmak üzere tüm siteler indesklenme noktasında negatif olarak etkilenecektir.

Tarama bütçeniz paylaşım sıklığınıza, paylaşım sayınıza paralel olarak artış göstermediğinde sitenizin eski sayfalarında yapacağınız güncellemelerin görüntülenmesi, yeni paylaştığınız içeriklerin taranıp dizine eklenmesi gibi süreçler aksayabilir. Özellikle web siteleri için organik trafik kazanımının ilk şartı olan indekslenme süreci aksadığında web trafiği kazanımı ilgili durumdan negatif etkilenecektir.

A+ bir sitenin gün içerisinde 10.000 sayfası taranırken ortalamanın üzerinde seyreden seviyede (sayıda) hatası olan, tarama bütçesi tükenmiş yada çok kısıtlı olan bir sitenin büyüklüğüne bakılmaksızın 6 sayfası taranıyor olabilir.

Tarama Nedir?

Tarama, internet dünyasında bir web sitesinin ziyaret edilerek, incelendiği (görüntülendiği) sürecin tümüne verilen isimdir. Tarama ifadesi ile gerçekleştirilen işleme bağlı olmak üzere pek çok farklı işlem kast ediliyor olabilir ancak en temelde tarama ifadesi ile bir web sitesinde yer alan sayfaların (URL’lerin) ziyaret edilerek kontrolü kast edilmektedir.

Tarayıcı Nedir?

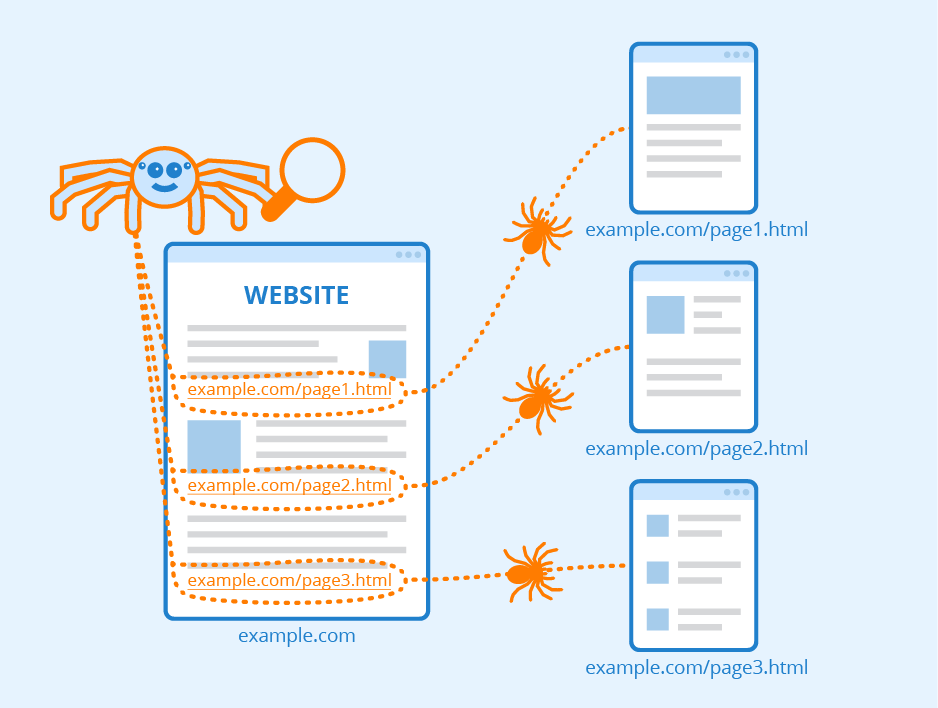

Web dünyası için olmazsa olmaz elementlerin başında gelen tarayıcı (web crawler) ifadesi ile web sitelerini sayfalarını (URL’lerini) kontrol etmek, incelemek amacı ile ziyaretler gerçekleştiren botlar, arama motoru örümcekleri kast edilir.

Web dünyasında yer alan sitelerin ve web sayfalarının arama motorları tarafından keşfedilip, incelenmesi amacı ile kullanılan tarayıcılar ile web sayfalarına ziyaret gerçekleştirilir, ilgili sayfa taranır ve sayfa ile alakalı bilgiler arama motoruna aktarılır.

Tüm bu süreçlerin otomatize edilmesine katkı sağlayan arama motoru botları, tarayıcı olarak isimlendirilir.

Tarama Hızı ve Limiti Nedir? (Crawl Rate and Limit)

Arama motoru botlarının sitenizi tarama amacı ile saniyede kaç kez istekte bulunduğu Crawl Rate yani Tarama Hızı ifadesi ile belirtilir (Örneğin: Saniyede 3 istek). Çeşitli faktörlere bağlı olmak ile birlikte web sitenizin genel sağlığı arama motoru botlarının sitenizi tarama amacı ile gönderdiği istek sayısını ve bu istekler arasındaki süreyi yani tarama hızını doğrudan etkiler.

Site ve sunucu teknik sağlığının bozuk olduğu durumda arama motoru botları sitenize gönderdiği istek sayısını ve istek hızını azaltabilir. Bir web sitesinin tarama istek hızının (tarama hızı) azalmasında etkili olan temel sebeplerden bazıları aşağıdakilerdir;

- Google search console tarama hızı direktifleri ve veya robots.txt direktifleri gibi kontrol araçları ile arama motoru botlarının tarama hızı negatif yönde düzenlenebilir. (Örn: User-agent:* Crawl-Delay: 10 – Bu direktif ile arama motoru botlarına siteye 10 saniye aralıklarla istek göndermesi gerektiği bildirilebilir. Bu direktif sonrasında daha öncesinde hızlı olan bir tarama sıklığı 10 saniye üzerinden ilerleyecek şekilde yavaşlayabilir.)

- Web sitesinin tarama sağlığı: Web sitesinin gerek site içi (on page) gerekse sunucu tarafında karşılaştığı teknik hatalar tarama hızının düşüşüne neden olabilir. Örneğin çok sayıda http 500, connection timeout gibi server kaynaklı hatalar ile karşılaşılan web sitelerinin tarama hızı ve sıklığı Googlebot tarafından azaltılabilir.

Bir web sitesinin arama motoru isteklerine verdiği yanıt süresi doğal sebeplerden uzadıkça Googlebot gibi arama motoru botları, ilgili web sitesinin sunucusunun istekleri karşılamada yetersiz olduğunu düşünerek istek sayısını azaltabilir.

Tarama Talebi (Crawl Demand) Nedir?

Tarama talebi (Crawl Demand), arama motoru botlarının web sayfalarınızı ne kadar taramak istediğini belirtmek amacıyla kullanılan terimdir. Tarama bütçesi ifadesi ile en temelde kast edilen terim olan tarama talebi sayısının azalması her zaman için bir soruna işaret etmez. Paylaşım sıklığı, içerik popüleriği, içeriklerin güncelliğini yitirmesi gibi etmenler bir web sitesinin teknik anlamda sorunsuz olan tarama bütçesini, arama motoru tarama isteğinin azalması ile etkileyebilir.

Google gibi arama motorlarında web sitelerinde yer alan içeriklerin, dizine eklenmesine gerek duyulmadığı yada içeriklerin dizinde güncellemeye ihtiyaç duyulmadığı durumlarda tarama talebi sayısı azaltılabilir. Aynı şekilde site tarafından paylaşılan içerik sıklığında yaşanan artış yada azalma, içeriklerin belirli periyodlar, ritimler ile paylaşılması gibi durumlarda tarama talebi sayısını değiştirebilir.

- İçeriğin Popülerliği: Bir içeriğin arama sonuçlarındaki popülerliği ilgili içeriğin özellikle Google gibi arama motorları için olan önemini arttırmaktadır. Bu noktada popülerliği yüksek olan içeriklerin indekste güncel kalmasını sağlamak amacıyla arama motorları (Google) ilgili içeriğin (URL’nin) tarama talebi sayısını arttırabilmektedir. Otoriter ve çok sayıda içeriği aramalarda popüler olan web sitelerinin tarama talebi sıklığı artış gösterebilir.

- Güncelliğin Kaybı: Popülerliğe bağlı olarak artan ve azalan tarama talebi sayısına benzer olarak güncelliğini yitirmiş içeriklerin arama motoru sonuçlarından silinmesini sağlamak amacıyla arama motorları tarama talebi sayısını azaltıp, bir sayfayı dizinden kaldırabilir.

Tarama Bütçesi Neden Önemlidir?

Tarama bütçesi, web sitesinin taranabilirliğinin temelini oluşturan bir faktör olarak SEO süreçleri ve teknik SEO sağlığı için olmazsa olmazdır. Teknik yapısı hatalı olan, çok sayıda yönlendirme zincirlerine sahip, kopya içerikler, yönlendirme eklenmemiş HTTP 404 linkleri gibi bütçe tüketen linklere sahip siteler tarama bütçelerini negatif anlamda tüketip orta uzun vadede indekslenme sorunları ile karşılaşılabilirler.

En temelde Google başta olmak üzere arama motoru botlarının site sayfalarınızı herhangi bir negatiflik ile karşılaşmadan taraması, tarama bütçenizin artarak, arama motoru örümceklerinin sayfalarınızı sorunsuz görüntüleyebilmesini, sitenizde gerçekleştireceğiniz değişiklik ve güncellemeleri takip edilebilmesini ve finalde sitenizin arama sonuçlarında sıralama almasını dolaylı olarak etkileyecektir.

Bir web sitesinin kalitesinin ve içerisinde yer alan içeriklerin arama motoru botları tarafından keşfinin ve değerlendirilmesinin en temelinde yer alan taranabilirlik, arama sonuç sıralarına sağladığı doğrudan ve dolaylı etki ile SEO süreçleri için son derece önemlidir.

Buna ek olarak tarama limitleri için ayrılan kaynakların kısıtlı olduğu düşünüldüğünde özellikle Google gibi çekirdek algoritmaları son derece gelişmiş arama motorları için gereksiz sitelere ayrılacak tarama kaynaklarının mantıklı, güvenilir, kaliteli web sitelerine aktarılarak kaynakların verimli yönetilmesi son derece önemlidir.

Özetle; Tarama bütçesinin organik trafik için önemini son derece düz bir mantık ile basitçe açıklamak mümkündür. Tarama yoksa indeksde yok, Indeks yoksa kullanıcıda yok. Tarama bütçesinin en temel anlamda önemini bu şekilde özetleyebiliriz.

Arama Motorları Neden Tarama Bütçeleri Kullanır?

Web dünyasında yer alan tüm sayfaların taranarak ilgili verilerin depolanması ve bu süreçler için gereken enerji kaynaklarının kısıtlığı konusu tarama bütçelerinin aktif olarak arama motorları tarafından kullanılmasının en temel sebebidir. Günümüzde var olan milyarlarca sayfaya her gün açılan yeni web siteleri ve web sayfalarının eklendiği düşünüldüğünde üste üste eklenerek genişleyen internet dünyasının tamamını taramak için gereken kaynakların yetersizliği, limitli olması tarama bütçelerinin kullanılmasının en temel sebeplerinden bir tanesidir.

Tarama Süreci Nasıl İşler?

Bir sayfanın tarama süreci, en temelde sayfaya bir arama motoru botunun ziyaret gerçekleştirmesi, ilgili web sitesinin robots.txt dosyasının görüntülenerek tarama direktiflerinin kontrol edilmesi ve sayfada yer alan içeriği taranmasına dayanır.

Bir sayfanın arama motoru botları tarafından taranıp taranmayacağı robots.txt dosyasında yer alan allow, disallow komutlarına göre belirlenir. Bir arama motoru botuna herhangi bir sayfanızın taranmasını istemediğinizi belirtmek istediğinizde robots.txt dosyası üzerinden ilgili URL adresini belirtmelisiniz.

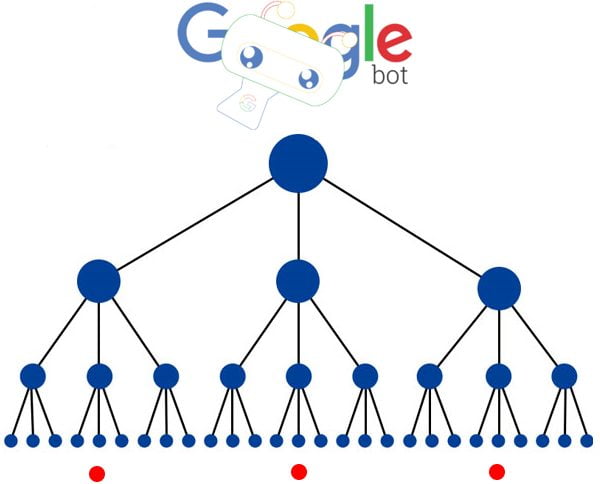

Taranabilir bir URL üzerinden sayfaya ulaşan arama motoru botları sayfanın kaynaklarını barındıran web servera istek göndererek sayfayı oluşturan HTML, CSS, JS, Resimler gibi kaynakları alır ve sayfanın ne ile alakalı olduğunu çözümlemek için sayfayı oluşturur. Oluşturma süreci sonrasında sayfanın alaka durumuna göre ilgili sayfayı dizine kaydetmek üzere veritabanına (search index) gönderen botlar, ilgili sayfada yer alan linkleri (HTML, JS vb) takip ederek web de yer alan yeni sayfaları keşfeder.

Arama motoru botlarının web’i taramasının anahtarı olan linkler vasıtasıyla arama motorları daha önceden bildikleri sayfalara ulaşır ve o sayfalarda yer alan yeni linkleri takip ederek yeni sayfaları keşfeder. Bir sayfanın HTML DOM’u içerisinde yer alan tüm linkler (header,footer,sidebar dahil olmak üzere) arama motoru botları tarafından keşfedilir ve taranır.

Sayfalar üzerinde yer alan linklerin takibi ve keşfine ek olarak yeni sayfaların bulunma ve taranma süreçlerinde sitemapler’de aktif rol alır. Web sitenizin arama motoru botları tarafından kolay taranabilir olmasını sağlamak için site haritaları oluşturarak bunları search console gibi arama motoru panellerinde belirtebilir ve oluşturduğunuz site haritalarını robots.txt dosyanıza ekleyebilirsiniz. (Örnek: Sitemap: https://www.example/sitemap.xml)

Tarama Bütçesini Etkileyen Faktörler Nelerdir?

Tarama bütçesini negatif olarak etkileyen en temel faktörlerin başında içerik kalitesi gelmektedir. Google gibi algoritmaları gelişmiş arama motorları her geçen yıl geliştirdikleri algoritmalar ile zayıf içerikleri çok daha etkili şekilde ayırt etmeye, tarama bütçelerini etkili şekilde kullanmaya ve zayıf içerikleri arama sonuçlarının dışında tutmaya başlamışlardır. Bu sebeple kaliteli, özgün ve güvenilir içerikler üretmek tarama bütçesinin sağlıklı seviyelerde tutulmasında önemli faktörlerden bir tanesidir.

İçerik kalitesine ek olarak tarama bütçesini etkileyen pek çok farklı faktör mevcuttur. Bunlar ;

Soft (HTTP 404) Hataları

Soft 404 olarak adlandırılan sayfalar, genellikle istemcinin istek gönderdiği sayfa ile alakalı içeriği barındırmayan ve bu durumda HTTP 404 durum kodu döndürmek yerine HTTP 200 durum kodu döndüren sayfalardır. Örneğin: Stok olmadığı için siteden silinen bir ürün sayfası, içerik olarak sayfaya ulaşılamadı lütfen şurayı ziyaret edin mesajı döndürüyorsa ancak HTTP durum kodu olarak da 404 yerine HTTP 200 döndürüyor ise bu sayfa Soft 404 olarak işaretlenir.

Çok sayıda Soft 404 sayfaya sahip web sitelerinin tarama bütçesi aynı HTTP 404 kodlu sayfalarda olduğu gibi boşa tükenir. Çünkü ilgili sayfa içeriksel anlamda bir şey ifade etmiyor olmasına karşın yanıt kodu olarak http 200 döndürdüğünden ötürü gereksiz yere arama motoru botları tarafından istek alır ve hem botlar hem de kullanıcılar için reel anlamda bir değer sunmaz. Bu tarz sayfaların HTTP 410 (Gone) durum koduna güncellenmesi yada alakalı sayfasına 301 yönlendirme ile yönlendirilmesi gereklidir.

Hacklenmiş Sayfalar

Hacklenmiş sayfalar adı üzerinde olduğu gibi içeriği değiştirilmiş, saldırıya uğramış sayfalar olduklarından hem arama motorları hem de kullanıcılar için bir değer sunmazlar. Özellikle hacklenen siteler ve sayfaların Google gibi arama motorları gözünde güven değerleri önemli ölçüde sarsıldığından bu tarz sayfalara sahip web sitelerinin tarama sıklığı (bütçeleri) ilgili durumdan negatif olarak etkilenecektir.

Yönlü Gezinme Menüleri ve Oturum ID’leri (Parametreler)

Başta e-ticaret siteleri olmak üzere web sitelerinin pek çoğunda kullanıcıların site içi aradıklarını daha kolay bulmalarını sağlamak amacıyla kullanılan yönlü gezinme menüleri (faceted navigations), doğru kullanılmadıklarında tarama bütçelerini negatif tüketebilirler. Çünkü kullanım yapıları gereği bir sayfanın daraltılmış farklı versiyonlarını filtreleyerek bunları farklı URL’ler üzerinden kullanıcılara sunabilen yönlü gezinme menüleri, doğru düzenlemeler yapılmadığında bir sayfanın çok sayıda kopya farklı sayfalarını oluşturarak sitenin tarama bütçesinin negatif tüketilmesine ve içeriksel sinyallerin hatalı şekilde iletilmesine neden olabilirler.

Bu gibi durumların önüne geçmek adına yönlü gezinme menüleri kullanılan sitelerde ana içerik sayfasına benzeyen ve içeriksel anlamda özgün bir değer sunmayan sayfalar arama motoru botlarının taramalarına kapatılmalı ve no indeks olarak işaretlenmelidir.

Oturum ID’leri ve parametreler üzerinden bir içerik sayfasının kopya versiyonlarını oluşturan web sitelerinde kopya içerik sorununun önüne geçmek adına kullanıcı ID’si gibi parametrelerden oluşan kopya sayfaların arama motoru botları tarafından taranabilirliği engellenmeli ve ilgili sayfalar no indeks olarak işaretlenmelidir. (Mevcutta botlar tarafından taranıp dizine eklendilerse öncelikli olarak sayfalar dizinden düşürülmeli ve sonra taramaya kapatılmalıdırlar).

Kopya İçerik

Bir içeriğin kopya versiyonları arama motoru botları tarafından tarandığında Google gibi kuvvetli algoritmalara sahip arama motorları sitenin tarama istek sayısını azaltabilir. Bu gibi durumların önüne geçmek adına birbirinin kopyası olan URL adresleri taramalara kapatılmalı ve sitede kopya içeriğe yer verilmemelidir.

İç Linkleme

Tarama bütçesini olumlu yönde etkileyen faktörlerden olan iç linkleme, site içerisinde birbiri ile alakalı olan sayfaların birinden diğerine link vermesi yolu ile gerçekleştirilen bir çalışmadır. Arama motoru botlarının yeni sayfaları linkleri takip ederek keşfettiğini bildiğimizden iç linkleme yolu ile önemli sayfalarımızı arama motoru botlarına belirtebilir ve sitemizin tarama bütçesini olumlu yönde geliştirebiliriz.

Zayıf ve Spam içerikler

Çok sayıda zayıf ve spam içeriklere sahip web siteleri, arama motoru botları tarafından taranıp kalitesiz bir site olarak işaretlendiklerinde içerik kalitelerine paralel olarak tarama bütçeleri azaltılabilir. Bu gibi durumların önüne geçmek adına zayıf, kullanıcı için bir değer ifade etmeyen ve en önemlisi spam olan içerikler siteden temizlenmelidir.

Yönlendirme Zincirleri

Yönlendirme zincirleri, bir URL’den başlayan ve URL adreslerinin sırayla başka bir URL adresine yeniden yönlendirme gerçekleştirmesi sonucu oluşan yapılardır. Bir web sayfasında yönlendirme zincirinin bulunması o sayfaya istek gönderen arama motoru botlarının kotasının gereksiz yere tükenmesine sebebiyet verebilir. Bu nedenle çok sayıda yönlendirme zincirine sahip web sitelerinin tarama bütçeleri arama motorları tarafından azaltılabilir.

HTTP 404 Linkler

Web sitesinden silinen yada hatalı URL üzerinden istek gönderilen web sayfaları HTTP 404 (Client Error) durum kodu ile yanıtlanır. Bu noktada silinmiş içerikler için ilgili içeriğin tamamen silinip silinmediği ile alakalı HTTP 410 (Gone) benzeri bir durum kodu döndürülmediğinde arama motoru botları ilgili içeriğin yeniden yayına alınma ihtimalini düşünerek ilgili URL’e tekrar ziyaretler gerçekleştirebilirler. Bilinçli bir şekilde sitenizden komple sildiğiniz sayfaların 301 yönlendirmesini yada alakalı durum kodu güncellenmelerini yapmadığınız durumda HTTP 404 durum kodlarına sahip URL’ler tarama bütçenizi negatif olarak tüketebilirler.

Site haritanızdan yada aktif olarak kullanılan içerik sayfalarınızdan HTTP 404 durum koduna sahip URL adreslerine verilen linkler tarama bütçenizi negatif olarak tüketir. Site içi linklemelerde ve site haritasında tarama isteklerinin boşa tüketilmemesi adına HTTP 301 ve HTTP 404 durum koduna sahip URL adreslerine link verilmemelidir.

İçerik Kalitesi

Yazı içerisinde pek çok kez değindiğimiz içerik kalitesi hem tarama bütçesini hem de arama sonuçlarını doğrudan etkilemesi sebebiyle son derece önemli bir faktördür. Kaliteli içeriklere sahip, yayın yaptığı kategoride otoriter olan, kendi sektörü için uzmanlığını ve kalitesini ortaya koymuş web sitelerinin tarama bütçesi, site içerik kalitesine paralel olarak artış gösterecektir.

Web site Hızı

Kullanıcılar gibi arama motorları da hızlı yanıt döndüren, hızlı açılan web sitelerini tercih ederler. Bu noktada özellikle sağlıklı ve hızlı çalışan bir sunucuya sahip, açılış hızları optimize edilmiş web sitelerinin tarama istek sayısında ve tarama hızında artış gerçekleşecektir.

Sunucu Sağlığı

Sunucu teknik yapısı doğru şekilde düzenlememiş, konfigürasyonları ve direktifleri hatalı yada sunucu kapasitesi siteye gelen istekleri karşılamaya yeterli olmayan web sitelerinde gereğinden fazla şekilde HTTP 500 vb hata kodları ile karşılaşılması son derece olasıdır. Sunucu kaynaklı şekilde gerçekleşen HTTP 500 vb (5xx) hata kodlarına sahip web sayfaları arama motorlarının tarama isteklerini boşa tüketerek site ile alakalı negatif kalite sinyallerinin oluşmasına sebebiyet verebilir. Bu gibi durumlarda arama motoru botları sitenin sunucu yapısının sağlıksız olduğunu düşünerek tarama istek sayısını ve hızını azaltabilir.

Tarama Bütçesi Nasıl Optimize Edilir?

Tarama bütçesi optimizasyonu üst kısımda değindiğimiz tarama bütçesini etkileyen faktörlerinin tümünün yada önemli bir bölümünün sorunsuz olacak şekilde optimize edilmesine dayanır. Burada yer alan maddelerin her biri kendi içerisinde farklı kriterlere ve önem seviyelerine sahipken bazıları site genelinde pek çok farklı kriteri doğrudan etkilediğinden önem ve öncelik seviyeleri yüksektir.

Sayfalarınızın Teknik Hatalarını Düzeltin

Tarama bütçenizi optimize etmek ve boşa harcanmayan tarama bütçeleri elde etmek için sitenizde yer alan tüm sayfaların teknik yapılarını kontrol ederek hatalı sayfalarınızı mümkün olan en hızlı şekilde düzenlemelisiniz.

Üst bölümde tarama bütçesini etkileyen faktörler olarak belirttiğimiz soft 404 sayfaları, http 404 durum koduna sahip sayfalar, yönlendirme zincirleri ve http 5xx (500 vb) hata kodlarına sahip sayfalar sitenizin tarama bütçelerini negatif tüketirler. Bu nedenle sitenizden komple sildiğiniz http 404 hata koduna sahip sayfaları 301 yönlendirme ile varsa alakalı bir sayfasına yada üst kategorisine veya alakalı hiç bir sayfası yok ise http 410 durum koduna güncelleme yapmalısınız. Buna ek olarak soft 404 hatalarını kontrol ederek çözmeli ve sitenizde yer alan tüm yönlendirme zincirlerini, tek yönlendirme yapacak şekilde güncellemelisiniz.

HTTP 500 vb sunucu kaynaklı hata koduna sahip sayfalarınızı kontrol ederek yanıt kodunun nedenlerini belirlemeli ve sunucunuzun tüm performans, konfigürasyon sorunlarını optimize etmelisiniz. Sunucu kaynaklı http 500 durum koduna sahip sitelerin taranabilirlik ve ulaşılabilirlik problemleri, indeks sorunu, sıralama kayıpları gibi sonuçlara neden olacağından son derece önemlidir. Özellikle gün içerisinde gelen istekleri karşılaşmakta yetersiz olan, zorlanan sunucular sıklıkla HTTP 500 kodlu yanıt kodlarını döndürebilirler. Bu durumda çok sayıda http 500 hata koduna sahip web sitelerinin tarama bütçeleri, arama motorları tarafından azaltılabilir.

Sitenizin Belirli Bölümlerini Taramaya Kapatın

Sitenizin sepet, kullanıcı sözleşmesi , teşekkürler, filtreleme sayfaları ve site içi arama sonuçları gibi Google botları tarafından taranması ve indekslenmesi gerekmeyen sayfalarını robots.txt dosyanız üzerinden engelleyin.

Robots.txt dosyası kullanarak yapılacak engelleme sayesinde yukarıda anlattığımız tarama süreci içerisinde Google botları robots.txt dosyanızı kontrol ederek tarama dışında tutmak istediğiniz sayfaları sürecin dışında tutacaktır. Bu sayede tarama bütçenizi verimli şekilde kullanarak önemli sayfalarınızın daha sık şekilde taranmasını sağlayabilirsiniz.

Site Hızını Arttırın

Google tarafından pek çok kaynakta onaylandığı şekilde sitenizin genel açılış hızlarında yaşanacak artışlar, Google botlarının sitenizi daha hızlı ve daha fazla taramasını sağlayacaktır.

Sitenizin güncel hız sonucunu Google Page Speed üzerinden test ederek site hızınızın arttırılması ile alakalı önerileri Google’dan alabilir ve bu alanlara yönelik çalışmalar gerçekleştirerek açılış hızlarınızı arttırabilirsiniz.

Sunucu Hızını Arttırın

Site hızını on page (kod) noktasında geliştirmeye yönelik çalışmaları hayata geçirdikten sonra göz atmanız gereken bir diğer önemli faktörde sunucu hızlarıdır. Hızlı yanıt sürelerine sahip web sitelerinin tarama isteği sayısı ve tarama hızı, sunucu yanıt sürelerine paralel olarak gelişim gösterecektir.

Site İçi Linklemeye Özen Gösterin

Arama motoru botları, tarama sürecini optimize etmek adına çok sayıda dış ve iç linke sahip sayfaların tarama sürecinde öne alınmasına ve öncelikli olarak taranmasına önem gösterir.

Tarama sürecinde sitenizin sayfalarını tarayan arama motoru botları, taranmış sayfalar içerisinde yer alan site içi linkleri takip ederek bunları kuvvetli sinyaller olarak görür ve bu linklerde yer alan sayfaları hızlıca tarama sürecine dahil ederler.

Tarama sürecinde sitenizin sayfalarını tarayan arama motoru botları, taranmış sayfalar içerisinde yer alan site içi linkleri takip ederek bunları kuvvetli sinyaller olarak görür ve bu linklerde yer alan sayfaları hızlıca tarama sürecine dahil ederler.

Bu sebeple tarama hızını arttırmak ve tarama bütçesini optimize etmek adına arama motoru botlarına indekslenmesini istediğiniz önemli sayfalarınız ile alakalı sinyalleri site içi linkleme uygulayarak verebilirsiniz.

Site içi linkleme nedir, nasıl yapılır? isimli makalemize göz atarak site içi linkleme ile alakalı tüm bilgilere erişebilirsiniz.

Birbirine Benzer Kopya İçerikleri Kaldırın

Tarama bütçenizin negatif tüketilmesinin önüne geçmek ve siteniz ile alakalı olumsuz kalite sinyalleri göndermemek adına birbirine benzeyen özellikle de kopya içerikleri sitenizden kaldırmalısınız. Birbirine benzeyen, benzer sorguları hedefleyen içerikler cannibalization (içeriklerin birbiri ile rekabeti) adı verilen istenmeyen bir sıralama, rekabet problemine ve sitenizin tarama bütçesinin birbirine benzeyen iki ayrı içeriğe gereksiz yere bölünmesine sebebiyet verebilir. Bu nedenle mümkün olduğunca aynı sorguları hedefleyen benzer içerikleri tek sayfada birleştirmeye özen göstermelisiniz.

Buna ek olarak, özellikle birebir şekilde kopya durumunda olan üst bölümde de değindiğimiz şekilde yapısal, teknik nedenlerle oluşan sayfaları, mümkün olduğunca sitenizden ve arama motoru botları dizininden silmeli ve bu tarz sayfaların arama motoru botları tarafından taranamaz olduğundan emin olmalısınız.

Kopya durumunda olan içerikler, arama motoru botları tarafından taranıp dizine kaydedilmiş ise bu sayfaları önce noindex olarak işaretleyerek arama motorlarının dizinden sildirmeli ve sonrasında robots.txt disallow direktifleri kullanarak bu sayfaların botlar tarafından taranabilir ve indekslenebilir olmasının önüne geçmelisiniz.

Google gibi günümüzün başarılı arama motorları geliştirdikleri algoritmalar ile birebir kopya durumunda olan ve birbirine benzer sayfaların pek çoğunu algoritma dahilinde keşfederek bu sayfalardan bir tanesini dizine kaydetme yoluna gidebilir. Yine de bu tarz bir durumda kararın algoritmaya bırakılması ve gereksiz yere arama motorları için calculation cost (hesaplama maliyeti) yaratmamak adına kopya ve birbirine benzeyen sayfaların site yönetimi tarafında çözülmesi daha faydalı olacaktır.

Yetim Sayfaları Optimize Edin

Yetim (Orphan) sayfalar, site içerisinden yada site dışından herhangi bir şekilde link almamış web sayfalarına verilen isimdir. Yetim olarak adlandırılmalarının en temel sebebi site içerisinden (alakalı içeriklerden) dahi link almamaları sebebiyle önem seviyelerinin düşük olmasıdır.

Site içerisinde iç linkleme ile desteklenmemiş yada herhangi bir dış linke sahip olmamış sayfalar, Google botları tarafından ortalama sayfalara göre çok daha geç taranırlar. Bu sebeple sitenizde yer alan ve daha önce herhangi bir link ile desteklenmemiş sayfaları, iç linkleme methodu ile destekleyerek Google botlarının tarama listesine dahil edebilirsiniz.